A quanti mega va la tua connessione? Quanti giga pesa questo film? Di quanti tera è il tuo hard disk? Queste sono solo alcune di tutte le tipiche domande che oramai sentiamo ripetutamente ogni giorno. Ma che cos’è di preciso un mega, un giga o un tera? E che differenza c’è tra bit e byte? Per rispondere a queste e ad altre domande del genere eccoti perciò un apposito articolo nel quale andrò a spiegarti quali sono e come si misurano le unità informatiche.

Indice

Quali sono le unità informatiche

Proprio come avviene per le altre grandezze fisiche, quali la lunghezza o la massa, anche l’informatica ha le proprie unità di misura. A differenza però del metro e del chilogrammo, utilizzate come base rispettivamente per la lunghezza e la massa, nel mondo dell’informatica l’unità di misura fondamentale non è calcolata su base 10 – come avviene appunto nel sistema metrico decimale – bensì su base 2.

Questo poiché nell’informatica l’unità di misura fondamentale non è altro che il bit (termine che deriva dalla fusione delle due parole inglesi binary digit, pronunciato bàinari dìgit, in italiano cifra binaria) che a sua volta non rappresenta altro che l’unità elementare dell’informazione che può essere gestita da un qualsiasi computer, proprio perché i circuiti digitali – mediante i quali viene assemblato un qualunque elaboratore – sono in grado di “capire” solamente due diversi valori: o il valore 0 (zero), ovvero assenza di tensione, o il valore 1, ovvero presenza di tensione.

Questo poiché nell’informatica l’unità di misura fondamentale non è altro che il bit (termine che deriva dalla fusione delle due parole inglesi binary digit, pronunciato bàinari dìgit, in italiano cifra binaria) che a sua volta non rappresenta altro che l’unità elementare dell’informazione che può essere gestita da un qualsiasi computer, proprio perché i circuiti digitali – mediante i quali viene assemblato un qualunque elaboratore – sono in grado di “capire” solamente due diversi valori: o il valore 0 (zero), ovvero assenza di tensione, o il valore 1, ovvero presenza di tensione.

Come si misurano le unità informatiche

Nell’informatica di tutti i giorni le grandezze utilizzate non si fermano soltanto al semplice bit. Le unità informatiche più diffuse sono infatti rappresentate dai multipli del bit dei quali, quelli più utilizzati, sono soprattutto:

Nell’informatica di tutti i giorni le grandezze utilizzate non si fermano soltanto al semplice bit. Le unità informatiche più diffuse sono infatti rappresentate dai multipli del bit dei quali, quelli più utilizzati, sono soprattutto:

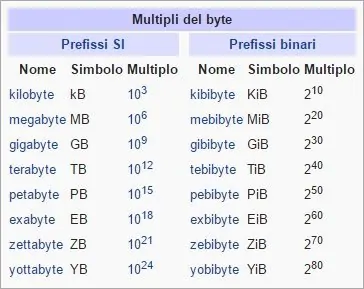

- il byte (scritto con la lettera iniziale b in minuscolo), termine inglese che deriva da bite (in italiano boccone, morso) e che si pronuncia bàit, che non equivale altro che alla somma di 8 bit. Il simbolo corretto del byte è B, cioè la lettera b in maiuscolo visto che la lettera b in minuscolo rappresenta invece il bit;

- il kilobyte (scritto con la lettera iniziale k in minuscolo), il cui corretto simbolo è kB (ossia con la lettera k in minuscolo e la lettera b in maiuscolo), che non equivale altro che a 1.000 byte;

- il megabyte (scritto con la lettera iniziale m in minuscolo), il cui corretto simbolo è MB (ossia con la lettera m e la lettera b entrambe in maiuscolo), che non equivale altro che a 1.000 kilobyte, ovvero a un milione di byte;

- il gigabyte (scritto con la lettera iniziale g in minuscolo), il cui corretto simbolo è GB (ossia con la lettera g e la lettera b entrambe in maiuscolo), che non equivale altro che a 1.000 megabyte, ovvero a un miliardo di byte;

- il terabyte (scritto con la lettera iniziale t in minuscolo), il cui corretto simbolo è TB (ossia con la lettera t e la lettera b entrambe in maiuscolo), che non equivale altro che a 1.000 gigabyte, ovvero a mille miliardi di byte.

Tutti questi ed altri multipli del bit sono solitamente utilizzati per indicare lo spazio richiesto o lo spazio a disposizione per ospitare uno o più determinati file. Ad esempio, se ti viene detto che un certo file pesa tre giga, ovvero 3 GB, vorrà dire che questo file richiederà – o meglio occuperà – 3.000 MB di spazio. Se invece ti viene detto che un hard disk ha una capacità di un tera, cioè di 1 TB, vorrà dire che questo potrà contenere al massimo 1.000 GB di dati.

Bisogna dire, comunque, che per comodità di calcolo i multipli del bit vengono generalmente arrotondati a potenze di 2 invece che a potenze di 10, benché questo sia formalmente sbagliato. Tale ambiguità ha portato l’IEC a definire tutta una serie di nuovi prefissi per multipli binari, sebbene finora siano quasi completamente sconosciuti. Questo poiché i vari produttori di dispositivi di archiviazione preferiscono ancora utilizzare i corretti, ma ambigui, multipli decimali in maniera tale da far figurare quantità maggiori di archiviazione proprio perché un determinato dispositivo di archiviazione con una capacità dichiarata di, ad esempio, 8 GB equivale in realtà all’incirca a 7,45 GiB di capacità effettiva.

Altre unità di misura

Oltre al bit, al byte e ai multipli di quest’ultimo, nell’informatica di tutti i giorni vengono molto spesso utilizzate anche tutta una serie di altre unità di misura. Tra queste, quelle più importanti da prendere in considerazione sono soprattutto:

- il bit per secondo (bit si scrive con la lettera iniziale b in minuscolo), il cui corretto simbolo è bit/s (talvolta però indicato anche come bps o b/s), che non rappresenta altro che l’unità di misura della quantità di informazione trasmessa su un canale di comunicazione;

- il kilobit per secondo (kilobit si scrive con la lettera iniziale k in minuscolo), il cui corretto simbolo è kbit/s (talvolta però indicato anche come kbps o kb/s), che corrisponde semplicemente a 1.000 bit per secondo;

- il megabit per secondo (megabit si scrive con la lettera iniziale m in minuscolo), il cui corretto simbolo è Mbit/s (talvolta però indicato anche come Mbps o Mb/s), che corrisponde semplicemente a 1.000 kilobit per secondo;

- il gigabit per secondo (gigabit si scrive con la lettera iniziale g in minuscolo), il cui corretto simbolo è Gbit/s (talvolta però indicato anche come Gbps o Gb/s), che corrisponde semplicemente a 1.000 megabit per secondo.

Queste ed altre simili unità di misura sono solitamente utilizzate per indicare la velocità massima di trasmissione dei dati su una comune rete informatica. Ad esempio, se a casa hai una connessione ADSL da 7 mega vorrà dire che la tua connessione avrà una velocità in download di, al massimo, 7 Mbit/s. Di conseguenza, siccome un bit equivale ad 1⁄8 di byte, potrai scaricare al massimo a 7 × 1⁄8 = 0,875 MB/s, ovvero al massimo a 0,875 megabyte al secondo. In aggiunta al bit per secondo e ai suoi multipli più diffusi, altre unità di misura molto utilizzate nell’informatica quotidiana sono anche:

- gli hertz (il cui corretto simbolo è Hz), che insieme ai più utilizzati multipli megahertz (il cui corretto simbolo è MHz) e gigahertz (il cui corretto simbolo è GHz) vengono soprattutto impiegati per indicare la frequenza di lavoro di un determinato processore. Ad esempio, un processore Intel può essere venduto con una frequenza di lavoro di 3.600 MHz, ossia di 3,6 GHz;

- i pixel, che insieme al più famoso multiplo megapixel (corrispondente ad un milione di pixel e abbreviato comunemente in MP) vengono solitamente impiegati o per indicare il numero di pixel che compongono una particolare immagine, o per indicare la risoluzione di un determinato schermo. Quest’ultima viene comunque in genere espressa come prodotto tra i pixel distribuiti in larghezza e i pixel distribuiti in altezza. Ad esempio, se un monitor ha una risoluzione di 1.280 × 720 pixel significa che sull’asse orizzontale del monitor possono esserci al massimo 1.280 pixel mentre sull’asse verticale possono essercene al massimo 720;

- i pollici, il cui corretto simbolo è in o il doppio apice “, che vengono sempre utilizzati per indicare le dimensioni della diagonale di un qualunque schermo. Ad esempio, 5,5″, 10,1″, 24″, 50″, e così via dicendo.

Arrivati dunque a questo punto dovresti aver finalmente capito sia quali sono le unità informatiche e sia come si misurano le unità informatiche.